就算在新产物满天飞,商业文明正在被 AI 重修的当下,我们仍然不知道,这些令人赞叹的手艺是若何运作的。

AI,语言模子,它是个黑箱(black box),人类无法明晰,我们甚至不知道怎样研究才气够明晰。

但若是,研究这个黑箱的不是人类,而是 AI 自己呢?

这是一个令人好奇但又异常危险的想法。由于你甚至不知道,这一研究方式发生的效果,是否会彻底推翻多年来人类对人脑和 AI 的明晰。

然则有人这样做了。几小时前,OpenAI 公布了最新的研究功效,他们用 GPT-4 注释 GPT-2 的行为,获得了劈头的功效。

绝不夸张地说,人们震惊极了:「求求你们让它离醒悟远点吧!」

「AI 明晰 AI,然后很快,AI 训练 AI,然后再过几年,AI 缔造新的 AI。」

但客观来说,学术界为之感应兴奋:「疯了,OpenAI 刚刚搞定了可注释性问题。」

人与机械之间是 GPT-4

OpenAI 刚刚在官网公布博客文章《语言模子可以注释语言模子中的神经元》(Language models can explain neurons in language models)。

简朴来说,他们开发了一个工具,挪用 GPT-4 来盘算出其他架构更简朴的语言模子上神经元的行为,这次针对的是 GPT-2,公布于 4 年前的开源大模子。

大模子(LLM)和人脑一样,由「神经元」(neurons)组成,这些神经元会考察文本中的特定纪律,进而影响到模子自己生产的文本。

举例来说,若是有一个针对「漫威超级英雄」的神经元,当用户向模子提问「哪个超级英雄的能力最强」时,这个神经元就会提高模子在回覆中说出漫威英雄的概率。

OpenAI 开发的工具行使这种规则制订了一套评估流程。

最先之前,先让 GPT-2 运行文本序列,守候某个特定神经元被频仍「激活」的情形。

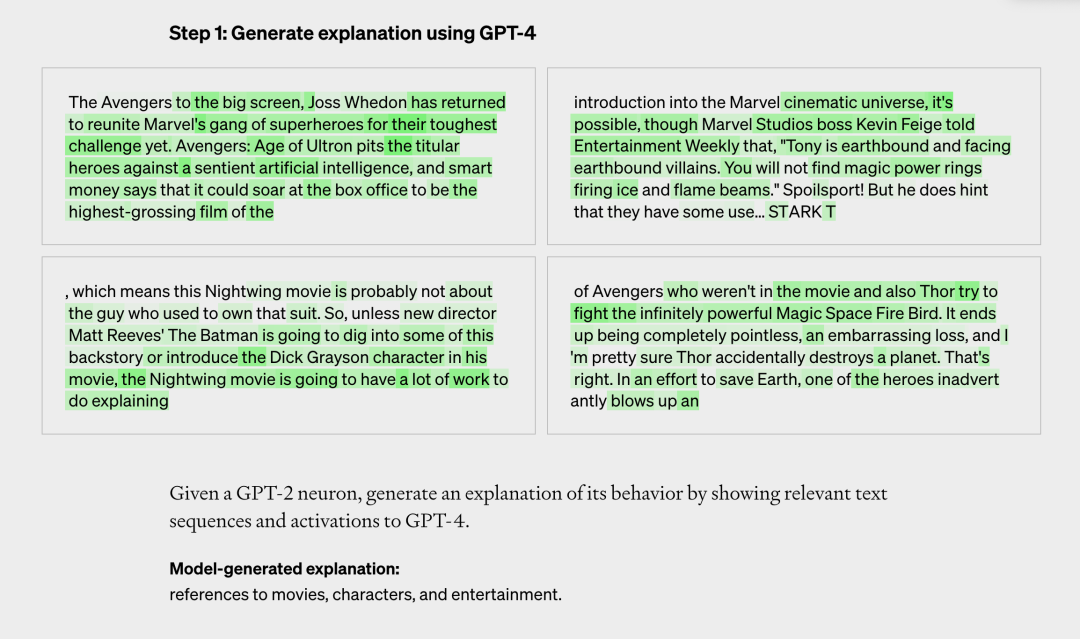

然后有三个评估步骤:

*步,让 GPT-4 针对这段文本,天生注释。好比在下面的案例中,神经元主要针对漫威内容。GPT-4 吸收到文本和激活情形后,判断这与影戏、角色和娱乐有关。

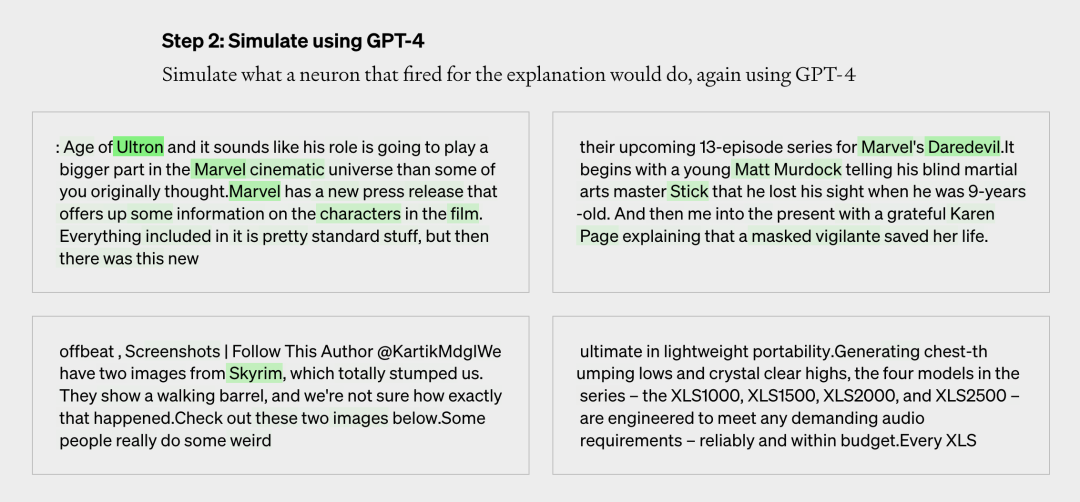

第二步,用 GPT-4 模拟这个 GPT-2 的神经元接下来会做什么。下图就是 GPT-4 天生的模拟内容。

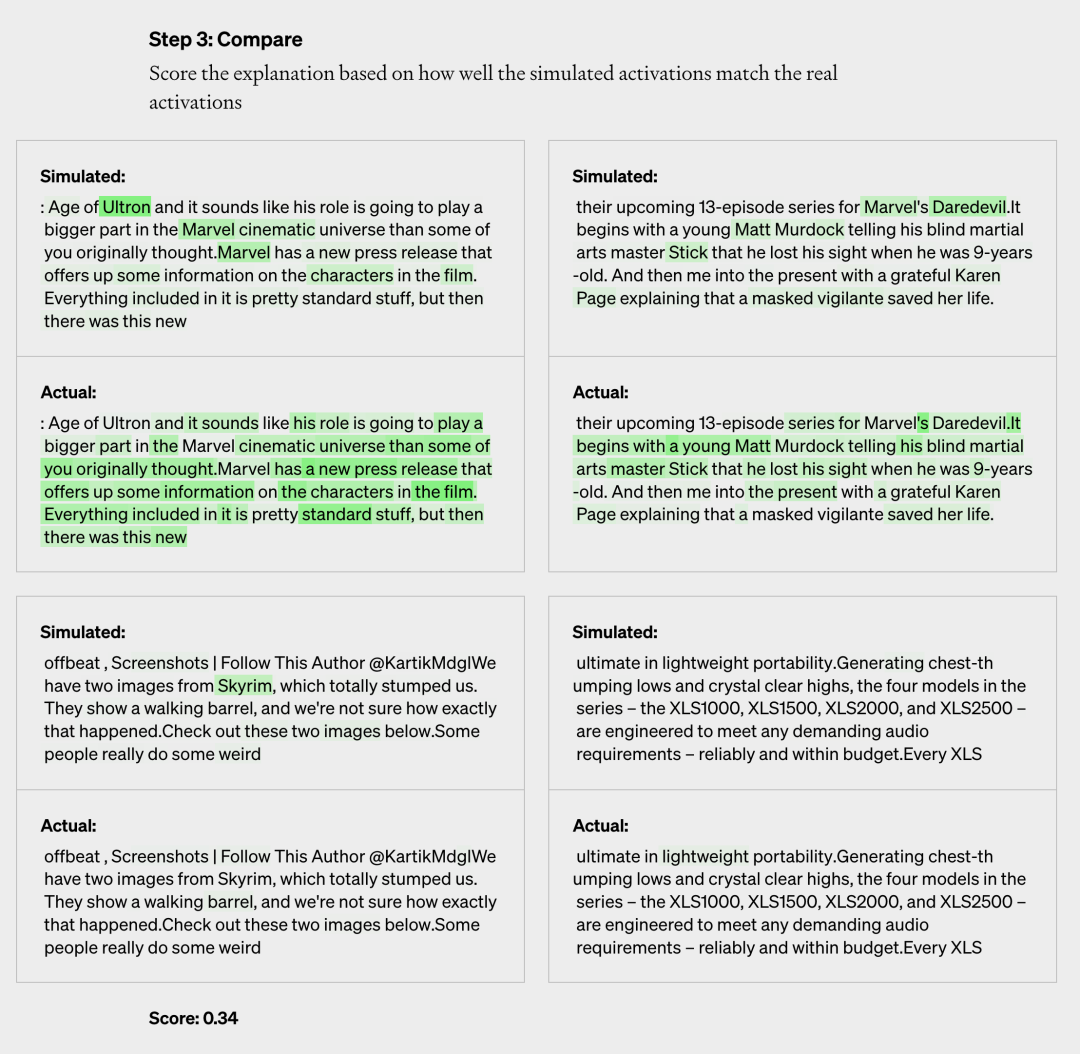

最后一步,对比评估打分。对比 4 代模拟神经元和 2 代真实神经元的效果,看 GPT-4 猜的有多准。

通过这样的方式,OpenAI 对每个神经元的行为作出了劈头的自然语言注释,并对这种注释和现执行为的匹配水平举行了评分。

最终他们对 GPT-2 中 307200 个神经元所有举行了注释,这些注释汇编成数据集,与工具代码一起在 GitHub 上公布。

逾越语言的机械

人类无法明晰的机械

据 OpenAI 在博客文章中示意,现在 GPT-4 天生的注释还不*,尤其要注释比 GPT-2 更大的模子时,显示效果很差,「可能是由于后面的 layer 更难明释」。

对于 GPT-2 注释的评分大多也异常低,仅有 1000 个左右的注释获得了较高的评分(0.8 以上)。

OpenAI 可拓展对齐团队的 Jeff Wu 示意,「大多数注释的得分很低,或者无法注释现实神经元那么多的行为。好比,许多神经元以一种难以判断的方式保持活跃,它们在五六件事上保持激活,但却没有可以鉴其余模式。有时刻存在显著的模式,但 GPT-4 有无法找到它。」

虽然现阶段成就欠好,然则 OpenAI 却对照有信心,他们以为可以使用机械学习的方式提高 GPT-4 产出注释的能力。

好比通过频频产出注释,并凭证激活情形修改注释;或者使用更大的模子作出注释;以及调整注释模子的结构等等。

OpenAI 还提到,这一方式现在尚有许多局限性。

使用简短的自然语言举行注释,也许并不匹配神经元可能异常庞大的行为,不能精练地举行形貌。神经元可能会具备多个差异观点,也可能,会具备一小我私人类没有语言形貌甚至无法明晰的观点。

最终 OpenAI 希望能够自动化找到并注释能够实现庞大行为的整个神经回路,而现在的方式只注释了神经元的行为,并没有涉及下游影响。

投资界24h | 领英突然宣布关闭,裁员700人;又一家新能源车企申请破产;中国人寿携手菜鸟物流成立30亿新基金

注释了神经元的行为,但没有注释发生这种行为的机制。这意味着纵然是拿了高分的注释,也只能形貌相关性。

整个历程是盘算麋集型的。

在论文中,OpenAI 示意:「语言模子可能代表了人类无法用语言表达的生疏观点。这可能是由于语言模子体贴差其余事情,好比统计结构对下一个token展望义务有用,或者由于模子已经发现了人类尚未发现的自然的抽象,例如在差异领域的类似观点家族。」

它把 LLM 的这种属性,称为 Alien Feature,在生物领域翻译为「异类特征」。

Founder Park 微信后台回复「注释神经元论文」,获取论文链接和中英对照 PDF 链接(机翻)。

把对齐问题也交给 AI

「我们正试图开生长望『AI 系统会泛起什么问题』的方式,」OpenAI 可注释性团队卖力人 William Saunders 对媒体说,「我们希望能够真正做到,让这些模子的行为和生产的回覆是可以被信托的。」

Sam Altman 也转发博客文章称:GPT-4 对 GPT-2 做了一些可注释性事情。

可注释性(interpretability)是机械学习的研究子领域,指的是对模子的行为有清晰的明晰和对模子效果的明晰能力。

简朴来说,目的就是注释机械学习模子「若何做到」(how)。

2019 年最先,可注释性成为机械学习的主要领域,相关研究有助于开发职员对模子举行优化和调整。针对当下 AI 模子大规模应用时,亟需解决的可信度(trust)、平安性(safety)和决议参考(decision making)等问题。

若是我们不知道 AI 是若何作出决议的,始终把它当做一个黑箱,那么就算 AI 在种种场景下显示得再*,也无法解决部门人类的信托问题。

OpenAI 这次使用 GPT-4 来解决可注释性的问题,就是希望能够使用自动化的方式,让机械完成 AI 研究。

「这是我们对齐研究的第三支柱的一部门:我们希望自动化对齐研究。令人期待的是,这一偏向能让它(对齐)与 AI 生长的措施相匹配。」

在 2022 年炎天,OpenAI 曾公布文章《我们做对齐研究的方式》(Our approach to alignment research)。

文中提到,宏观来看,OpenAI 的对齐研究将由三大支柱支持:

1、行使人工反馈训练 AI

2、训练 AI 系统协助人类评估

3、训练 AI 系统举行对齐研究

「语言模子异常适合自动化对齐研究,由于它们通过阅读互联网『预装』了大量有关人类价值观的知识和信息。开箱即用,它们不是自力署理,因此不会在天下上追求自己的目的。」

太快了

连认知都范式革命了

虽然 OpenAI 本意很好,然则这样的研究功效着实吓坏了网友。

OpenAI 的推文下梗图横飞,有不少人在认真地建议 OpenAI 搞慢点。

「用我们不明晰的器械,注释另一个我们不明晰的器械,这合理吗?」

「护栏都被你撤了」

「这太迷人了,但也让我感应极端不适。」

「自然缔造了人类来明晰自然。我们缔造了 GPT-4 来明晰自己。」

「我们要怎么判断注释者是好的?这就像... 谁监视着监视者?」(who watches the watchers)

尚有人看到了更深的一层:

「大模子很快就能比人类更好地注释他们自己的头脑历程,我想知道我们未来要缔造若干新的词汇,来形貌那些 AI 发现的观点(观点自己也禁绝确)?我们还没有一个合适的词形貌它们。或者,我们是否会以为这些观点有意义?它们又能教会我们若何熟悉自己呢?」

另一网友回应道:「人类自己对自己行为的注释,大多是谣言、捏造、幻觉、错误的影象、事后推理,就像 AI 一样。」